最近人工智能大热背后的功臣 - Deep Learning深度学习

这篇文章纯粹是写给我自己,也算是最近调研的总结。Deep Learning是最近人工智能大热的一个导火索,虽然已经被玩烂了,但是还是稍微补充一些这方面的知识。或许,人工智能的革命会越来越快呢?

1. 机器学习是做什么的

Deep Learning又叫做深度学习,最近人工智能的火爆,AlphaGo的成名,以至于各种语音识别技术(Siri等)突飞猛进,都离不开这几年Deep Learning级数的大发展。

首先,机器要实现所谓的人工智能,其中一个关键节点是模式识别,或者机器学习,其核心就是能够比如识别出人类的手写文字,识别出语音,在这一步基础上,才有后面的分析的步骤。

在机器学习或者模式识别领域,数十年下来已经了非常多成熟的算法,虽然他们在复杂条件下的准确率只有80%-90%,但是也足以适用绝大部分的场景,比如车牌识别。

传统的机器学习方法有神经网络(ANN),支持向量机(SVM),语音识别领域前些年大热的则是隐形马尔可夫模型(HMM),此外还有灰常多不同的工具和发明被各路大牛探索出来。

以语音识别的HMM为例,识别率大道90%左右则一直无法提升。虽然它已经超过了种种其他各种机器学习的方法,但是谁让人类就是这么挑剔呢,我们还是会因为机器听错一两句话而放弃他。

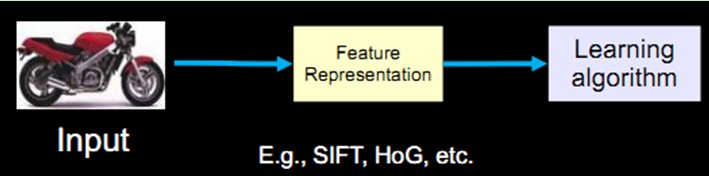

而在图像识别领域或者人脸检测领域,也发明了Boosting,ASM,AMM等特征识别方法。所有的机器学习方法不论如何,都绕不开一个流程:

想想我们人判断自行车,是基于他有2个轮子,没有动力,有把手等信息,这些特点我们就称为特征,在机器学习领域,特征的寻找就是一个非常关键的因素。

2. 从ANN人工神经网络说起

如果ANN的数学原理不懂,后面的内容则会很困难。

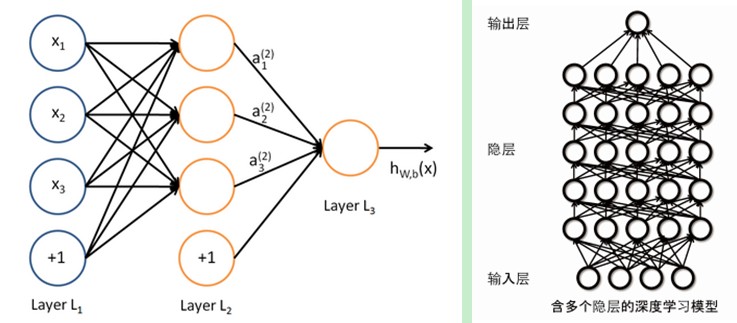

总之常见的ANN网络是BP网络,节点分为输入节点、隐藏节点、输出节点。ANN相比之前的SVM、Boosting等方法来说最大的优点在于:他的中间部分是黑盒,我们可以不需要人为筛选所谓的特征,让机器自动产生分类。

之所以神经网络80-90年代大热后急速冷却,是因为在识别拟合上很容易出现过拟合,或者陷入到局部最优解当中。虽然神经网络的原理非常像人脑的运转原理,但是由于不论科研工作者怎么努力,它在语音识别上的效果还不如HMM,所以后来逐渐冷却了。

Deep Learning的再度崛起,其实也是ANN的再度崛起,所以他们有什么区别呢?

3. ANN和Deep Learning的关系

2006年,加拿大多伦多大学教授、机器学习领域的泰斗Geoffrey Hinton和他的学生RuslanSalakhutdinov在《科学》上发表了一篇文章,开启了深度学习在学术界和工业界的浪潮。这篇文章有两个主要观点:

-

多隐层的人工神经网络具有优异的特征学习能力,学习得到的特征对数据有更本质的刻画,从而有利于可视化或分类;

-

深度神经网络在训练上的难度,可以通过“逐层初始化”(layer-wise pre-training)来有效克服,在这篇文章中,逐层初始化是通过无监督学习实现的。

在这里就不做更加深入的展开了。总之,Deep Learning和传统基于BP的ANN最大的区别在于训练方法的不同,但本质也是ANN:

-

Deep Learning会逐层学习,同时,他也不像传统的神经网络,是可以基于无标签的数据进行特征学习的,这个层面上来说更像人脑的工作原理。

-

Deep Learning的ANN采用的是卷积神经网络(CNN),一个特点是截零的方法和BP不同;另一个特点是神经元之间局部链接,这样做比BP网络的好处是极大降低复杂度。

所以Deep Learning的具体训练方法是:

-

使用自下上升非监督学习(就是从底层开始,一层一层的往顶层训练):采用无标定数据(有标定数据也可)分层训练各层参数。

-

自顶向下的监督学习(就是通过带标签的数据去训练,误差自顶向下传输,对网络进行微调)

具体我就不展开了,更多的东西还有待继续读论文研究。

最新Update:

现在在图像界,直接使用CNN+BP的方式比逐层训练效果还好,所以Deep Learning现在逐层训练的必要性已经不大了,和传统ANN的区别就是使用了CNN以及增加了深度。

科学界探索几十年,发现了某个Break Through,一堆聪明人扑上去之后,最后发现这个Break Through的影响因素并不是之前所预想的,而是某个犄角旮旯的点,想想也真是讽刺:)