关于Magic Leap,我还想再聊聊

这两天Magic Leap又放新视频了,朋友圈传的火热。VR的讨论又掀起了一阵风。但是,人家Magic Leap根本就不是VR好不好!甚至看到还有人把AR叫做人工现实。。。在我们深入扒开Magic Leap之前,先弄明白VR和AR的区别。

所谓VR,也就是Virtual Reality,虚拟现实提供的是沉浸的体验,比如HTC的Vive,以及Oculus。他们的特点是把你的视线全部遮住,用虚拟的环境代替。能想到的最大的使用场景无非2个:游戏和展示。

AR呢,也叫Augmented Reality,有过几种不同的形态。你或许以为的AR是这样的:

但是现实中目前冠名AR的App以及所有的产品都是这样的:

或者这样的:

前者是在特定的标记上渲染3D模型或者动画,有大量的开源库已经支持了,早期的就有ARToolkit,后来连Unity也开始有支持。它的原理也很简单,基于计算机视觉识别标记的角度,然后把3D模型旋转放大特定角度之后,重新在视频中渲染出来。

后者就更简单了,仅仅是在视频前面叠加了一层界面,最多就是根据陀螺仪(Compass)和GPS芯片来根据你的旋转角度和地理位置更新显示。看上去很美好,但是事实上你尝试过就会发现,使用起来的体验差到无法形容。(因为并没有使用视觉识别,它的标签显示完全无法精确的标记在特定物体上面)

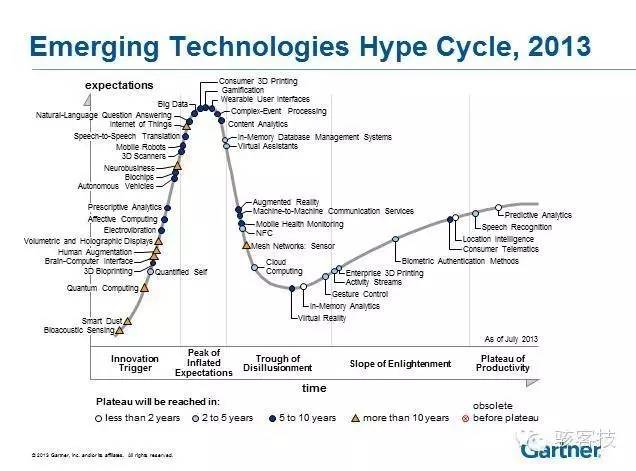

2009年我开始接触AR一段时间,后来很快就发现,就以当时的技术方案,还没有到火候。当时的AR以及VR用技术曲线画出来是这样的:

稍微解释一下这张图,这张图的横坐标是时间,划分为了5个区域,最后的区域是成熟阶段;纵坐标是大家对产品的期望。我们会发现,很多新产品出来的时候,比如大数据、3D打印,大家对它的期望很高,报道也非常多。随着时间的推移,由于早期产品的效果达不到大众的预期,关注度自然下降。在经过一段波谷之后,产品迭代进入成熟期,关注度和期望又会随之提升。

我们会看到,Virtual Reality还是走在Augmented Reality前面一点点的。

所以,现在AR又随着VR的大热火了,Magic Leap也框到了Google 10亿美金的投资。如果就是一个二维码识别的小纸片,它凭什么?

AR或许是下一个UI交互界面的革命

其实,从交互界面来思考,最早我们的交互界面是这样的(第一台计算机):

后来有了软件,就变成类似这样的:

再后来有了UI和鼠标:

后来是智能手机、平板电脑,UI交互进一步变小,变得离我们更近:

有人认为可穿戴或许是下一个交互界面,但是由于屏幕大小所限,可穿戴更可能的是人体感官、手机感官、传感器的延伸,而不会革新UI界面。

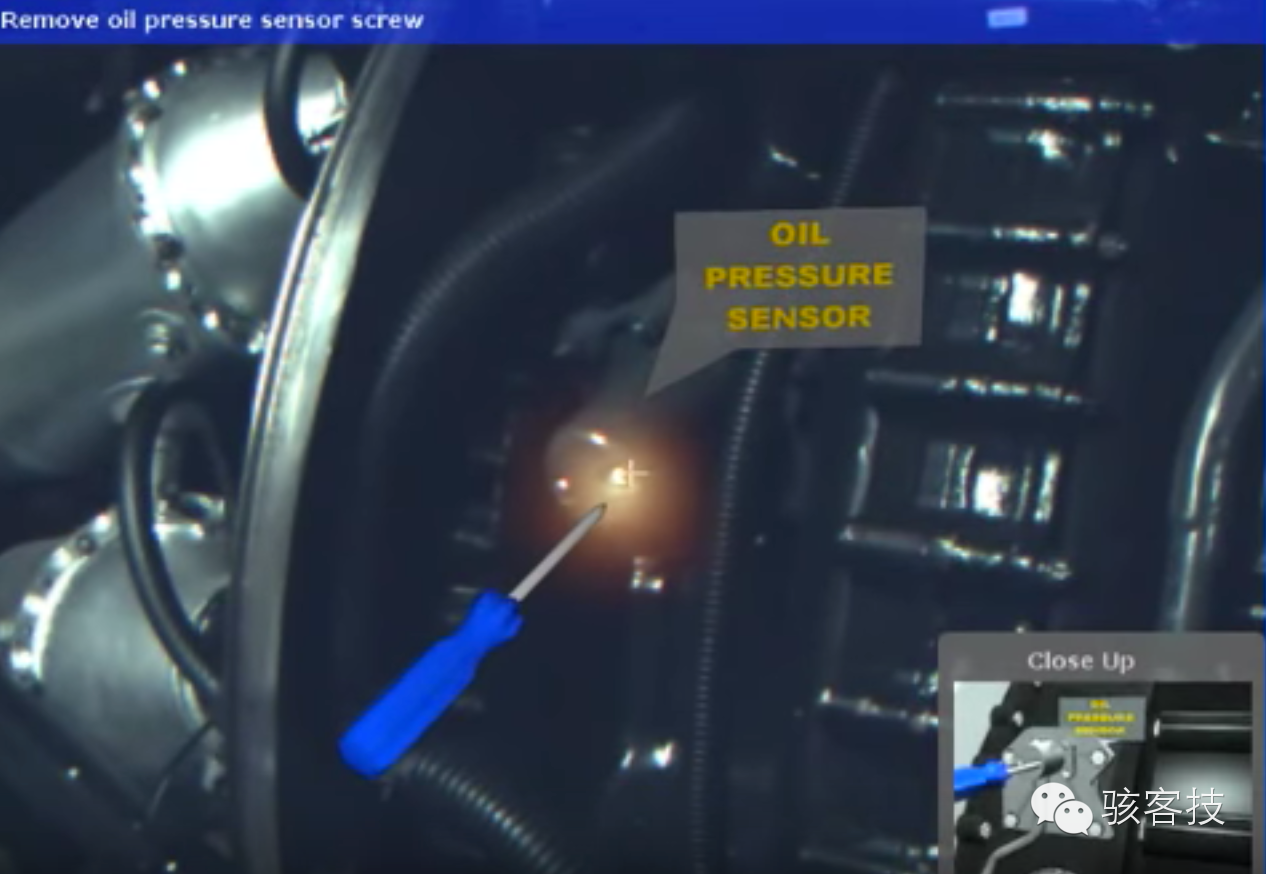

所以下一步呢?如果你自己动手修车的时候不知道下一步应该怎么做,你不需要打开手机查找,它已经把螺丝在哪,怎么操作全都告诉你了!

下面这张图其实是2009年的时候美国Columbia University和军方做的一个辅助军人在战场上紧急维修坦克等军用设施的预研。

所以,真正的AR不仅仅是在标记上显示3D,也不仅仅是在视频上叠加一层交互,而是结合机器视觉、定位技术、深度识别、实时搜索,3D展示的一整套大系统。

很可能,AR就是下一个UI界面的革新。

Magic Leap的技术

好了,说了这么多终于到了Magic Leap的正题上面。我们已经看到了这个技术的想象空间,接下来看看他们的技术到底牛逼在哪。

1. 实时的三维重建(SLAM技术)

SLAM的全称叫做Simutanious Localization And Mapping(实时定位与地图重建级数)。这个技术最早的文章是90年代的时候出来的论文,那时候绝大部分都在论文中以Matlab的方式出现。2000年之后,逐渐有很多大学以及科研机构在做机器人相关实验的时候,结合摄像头、低成本的雷达、Kinect,已经实现了很不错的效果,不如下面这个视频,就是用普通摄像头做的SLAM,机器人边走边建模:

Magic Leap中重建的3D物体能够在虚拟的空间中固定下来而不会随着镜头的移动而移动,很重要的原因是它做了3D的地图建模,并且通过陀螺仪把摄像头的位置以及速度信息全部纪录下来(Google无人车也在用这个技术)。

说到Google无人车,不得不提一个神人,Sebastian Thrun。他是Stanford的教授,带领学生拿了DARPA大奖之后,就去给Google的X Lab做无人车了。再后来,他整了个Google Glass,还不忘教育,回头做了个在线教育公司Udacity,也是MOOC(慕课)的创始人。他的Stanford老同事Andrew NG则整了个Coursera,以及去百度当首席科学家去了:)

说回来,SLAM需要结合深度识别、陀螺仪、加速度传感器等信息,实时的计算自身的运动轨迹,并且同时对周边的环境进行感知和绘制,这里需要耗费大量的计算资源,虽然算法(基于控制理论)已经很成熟了,但是要做到商用化,还有计算上的瓶颈。

2. 光场成像技术

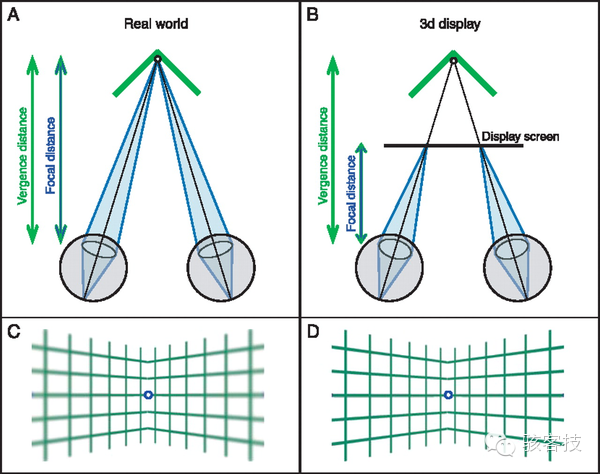

有人会说微软的HoloLense也用了SLAM技术,Magic Leap也没有什么大不了的。Magic Leap另一个黑科技就是光场成像技术,现在在知乎上面都已经有了大量的讨论,只不过由于Magic Leap到现在为之都没有放出他真正的技术文档,大家都是在猜想。那光场成像和电影院里面的3D电影有什么区别呢?

3D电影的景深是固定的,电影里面远处的物体并不会随着你视觉焦点的移动而清晰,这个是不符合自然规律的,而且还会产生聚散冲突(accommodation-vergence conflict),具体的原因是由于传统的双目视觉(Steoreo Vision)的成像方式,在单张图像上丢失了深度信息。

而Magic Leap的光场成像技术,和lytro光场相机的原理类似,它记录了物体完整的“光场”信息,并且重新通过激光投射到视网膜上,可以保证聚散匹配(accommodation-vergence matching),也就是说,你眼睛的视觉注视在哪,哪里就是清晰的,其他地方就是模糊的。

一个完整的光场,会记录所有的深度信息,所以比如你看下面的花,画面清晰的位置与你的视觉焦点强相关。

3. 计算速度

要知道Oculus为了不眩晕,需要达到120以上的帧数。这需要耗费大量的计算性能来进行3D渲染,这也是为什么Oculus只能在PC端使用不能在移动平台使用,计算性能不够呀!!!而Magic Leap,如果真的商用化了,SLAM需要耗费大量的计算性能,还要做光场成像,同时里面更有大量的计算机视觉识别的部分需要处理。现在没有任何资料表明Magic Leap已经解决了计算性能的问题,不过之前已经放出来了他们的光场芯片。

Magic Leap的团队:

Rony Abovitz是Magic Leap的创始人兼CEO,他建的第一家公司,Z-KAT,日后被MAKO医疗机械公司纳入麾下,这家公司是做机器人手术,并且已经上市了!

光场方面的技术,则是源于华盛顿大学前研究员Brian Schowengerdt的,他导师Eric Seibel是光纤扫描内窥镜(Scanning Fiber Endoscope)的专家。

计算机视觉以及SLAM等方面,Magic Leap则拉到了Gary Bradski和Jean-Yves Bouguet这样的大牛。像Gary Bradski普通人不了解,他可是计算机视觉的神级人物,OpenCV库的创始人,他还是ROS(机器人操作系统)的创始人,成果可谓不计其数。想当年我们多少个project都源于他首创的OpenCV。Jean-Yves之前则负责过Google街景车的制造,可谓是计算机视觉的大牛。

融资记录

来源于Crunch Base

- 2014年2月,5000万美金, Series A — 投资方未知

- 2014年10月,5.42亿美金,Series B — 6家公司,Google领投

- 2016年2月,8.27亿美金,Series C — 9家公司,阿里巴巴领投